《Linux是怎么样工作的》读书笔记

引言

这本书是集体看过的讲操作系统底层外面讲的最通俗易懂的了,然而200多页的内容的确讲不了多深的内容,所以不要对这本书抱有过高期待,当一个入门书理解即可。

书籍介绍

- 原富士通一线Linux内核开发工程师基于十余年教训执笔,业余实用

- 聚焦Linux外围性能,扼要易懂地解说操作系统是怎么工作的

- 198张示意图帮忙了解,详略切当,为读懂大部头开路

- 联合大量试验程序,边入手操作边学习,实在体验零碎运行过程

集体评估

内容比拟根底,然而无关Linux的内容都有波及,另外作者用C语言程序对于操作系统的缓存,替换内存,CPU过程管理器,固体硬盘和机械硬盘随机读写和程序读写做验证和测试的程序比拟有意思。

然而不得不说能把操作系统这种形象的货色讲的活泼形象实属不易,作者在日本一线大厂(能够翻翻富士通相干材料)搞Linux内核开发业余水平也毋庸置疑,另外这本书的编排是由浅入深的挺不错。

总结:十分难以定位的一本书,倡议能够参考外面的常识,依据相干内容深刻即可。

资源

2022年3月出版的一本书所以没有找到相干资源。

上面内容为随书一些C语言模仿操作系统底层工作的一些程序,感兴趣能够下载来看一下。

链接: https://pan.baidu.com/s/1eU65… 提取码: pghr

笔记索引

留神笔记的索引并不是依照原书的构造组织,因为集体浏览这本书是“倒着”读的,联合目录发现从后往前读比拟合乎集体的了解习惯,也就是从内部存储器到外部的工作机制比拟合乎集体的思考。

能够点击副标题跳转到相干的节点。

惯例的意识是常识由浅入深,其实有时候用难易穿插学习的形式可能更加合乎人的学习习惯

第一局部:Linux与内部构造介绍

次要介绍了机械磁盘和SSD硬盘的工作机制比照,程序读写和随机读写之间的差异,这部分应用C语言模仿磁盘的读写性能比拟有意思。

介绍了Linux和设施交互的文件系统设计,一共分为7层,当然书中只是简略演绎,如果要深刻须要浏览更多材料。

讲述了IO调度器和预读机制的相干内容。

第二局部:Linux文件系统设计

这一节讲述如何疾速的理解一个Linux文件系统的设计形式,文件系统的设计当然没有不是几页纸就能讲清楚的,然而对于咱们大抵理解Linux整体的设计思路入门还是不错的。

第三局部:计算机存储档次简析

如果你对笔记电脑或者台式机主板等等根本配置理解,或者对整个操作系统的工作过程有一个大抵的理解,这一节的内容齐全能够跳过。

计算机的存储器层级构造是越凑近CPU和CPU关系越亲密价格越高容量越小,咱们常见的存储器,速度从快到慢的排序是:寄存器 -> 高速缓存 -> 内存 -> 内部存储器,这一节则针对这几个存储层级进行介绍。

之后会介绍对于转译后备缓冲区,页面缓存,缓冲区缓存和Linux不常见也简直不应用的缓存调优参数。

第四局部:Linux内存治理和优化

针对内存的治理是操作系统过程治理外围和关键所在,此局部介绍了对于内存治理的内容,内存治理是整本书介绍最为具体的局部,集体认为外围是把握 请求分页和 写时复制,这两个个性被大量应用,除此之外了解内存的调配形式和调配的细节过程也是必要的。

另外这部分集体笔记在补充的同时也将内容拆分为高低局部:

- Linux内存治理

- Linux内存治理优化

第五局部:过程调度器

CPU过程调度目前支流的形式是两种,第一种是像window那样抢占式调度,每一个CPU可能会呈现调度工夫调配不等的状况,而另一种是工夫分片的形式,工夫分片是Linux 常见的过程调度器,特点是每一个过程有近似相等的CPU使用权,在应用实现之后立马交给下一个过程实现工作,应用分片的形式尽管可能导致一些重要工作提早,但这样的解决和调度形式使得零碎最为稳固。

过程调度器自身很简单,为了缩小复杂性作者没有做过多介绍,所以集体笔记内容也绝对较少。

第零局部:计算机程序概览

了解操作系统运行咱们须要理解无关计算机信息的根底概念,我想如果有想法去钻研操作系统底层多少对于计算机的根底理念不会生疏,所以这一部分集体当作总结。

附录

此局部是对于第一个局部物理磁盘的调配形式材料扩大,感兴趣能够浏览。

留神⚠:最初集体的笔记组织模式将会是难-易-难混淆的组织形式。

Linux与内部构造介绍

HDD磁盘介绍

机械磁盘从鸟瞰的逻辑构造了解为相似一个同心圆的多个圈,从外层到内层进行编号,磁盘通过顺时针程序编号,逆时针转动磁盘,这样解决是思考查找磁盘的时候能够间接依照程序扫描过来,磁头前进方向就是编号递增方向。

在上面的结构图中,磁道是每一个同心圆,而扇区指的是切割磁道所造成的“扇面”,因为切割之后的样子很像扇子的样子所以被称为扇区,扫描数据须要磁头在磁道上滑动,同时扇区会从0开始编号,一个编号对应一个扇区。

留神这是磁盘的俯视图,也就是说线的局部是物理磁盘上的“沟壑”,而扇区就是编号内的块。

上面是磁盘的侧面切面图,垂直叠加的盘通过一个磁盘一个磁头的组合,通过多磁头放慢数据的处理速度。

留神在HDD磁盘中一个扇区读写最小单位为512字节,而且每一个扇区都是512字节,不论扇区是在外层还是内层。

⚠️留神:很多框架或者数据库会把一次读写的大小设置为512字节,因为512是最小读写单位所以能够不须要额定的保护能够保障读写的原子性。

磁盘大小计算

最晚期磁盘能够通过上面的公式计算出整个磁盘的大小,因为磁道和扇区的数量是一一对应的:

存储容量=磁头数磁道(柱面)数每道扇区数*每扇区字节数

这样的设计有一个不言而喻的问题那就是无论扇区面积大还是小都是固定大小,很显然外层的扇区数据被白白浪费了。

针对这样的问题后续的机械磁盘呈现了改良,这项技术叫做ZBR(Zoned Bit Recording,区位记录)技术,这项技术依据每一圈的扇区来划分大小,同一个磁道圈内的扇区散布和大小雷同。

这意味着越是外层的扇区数量越多,而内圈则较少,在划分之后密度均匀分布。

因为磁盘扇区存储模式的改良,寻址模式天然也要跟着提高,现在的硬盘大多应用 、LBA(Logical Block Addressing)逻辑块寻址模式,理解这个寻址模式能力理解磁盘的大小的计算形式。

然而当初HDD的磁盘读写受限在随机读写速度上,过来HDD磁盘比拟风行的转速为7200转和5400转等等,区别的话是跑的快和跑的慢一点的蚂蚁。

尽管有SAS硬盘能冲破15000转,并且当初还有钻研团队钻研寻找不同资料或者其余形式冲破磁盘物理转速的限度(比方双磁盘转动的形式放慢旋转),然而始终无奈冲破机械磁盘的设计的物理限度。

市面上为什么支流贩卖7200转的磁盘和5400的转速的磁盘而不是别的磁盘?

一方面是7200的随机读写性能通过测试是最佳的,同时探讨一块磁盘的性能不能看程序读写的速度而是要看随机读写的速度。

针对机械磁盘存在一些物理壁垒,自东芝公司在1984年钻研出闪存之后,闪存技术不断进步,又通过了5年之后的1989年,SSD磁盘逐步走进历史舞台。

⚠️留神:为什么是7200转和5400转等等奇怪数字?

这两个数字都要从3600说起,计算机的前十年简直所有的硬盘都是3600转的,这个3600又是从哪里来的呢?因为美国的交流电是60Hz的!于是就有了上面的公式:

- 60Hz × 1转/Hz ×60秒/分钟 = 3600转/分钟

- 5400 RPM = 3600 RPM × 1.5

- 7200 RPM = 3600 RPM × 2

另外还有一个起因是专利抢夺,你会发现转速有15000却没有10000,9000,8000这种数字,其实都是因为整数和500的倍数转速都被专利注册了,然而专利注册者预计没想到转速能破万吧。

SSD磁盘介绍

SSD 的硬盘分为两种,一种是基于闪存颗粒的闪存固态硬盘,另一种是DRAM 硬盘。

闪存颗粒的硬盘也就是咱们古代笔记本电脑以及挪动固态少数应用的硬盘,这种磁盘的最大长处是能够挪动,同时数据的爱护不依赖电源就能够存储,在闪存颗粒中通常被分为 QLC,MLC,TLC,哪怕是寿命最短的QLC硬盘也有5-6年的寿命,而MLC寿命最长,爱护切当往往能够十几年失常工作。

⚠️留神:固态硬盘过来老本十分高所以机械磁盘是支流,宽泛遍及也就这几年工夫,所以下面说的内容都是现实状态。

在企业级的服务器应用的固态中通常以MLC为主,SSD磁盘的最大特点是不像是HDD一样受到物理冲击有可能造成整块磁盘不可用,然而SSD一旦损坏数据的修复老本很高或者说根本无法修复。

当初来看 SSD曾经十分便宜了,然而HDD的大数据低成本存储仍然很受一些用户欢送。

DRAM是介于机械磁盘和固态硬盘两头的模式,其采纳DRAM作为存储单元,它效仿传统硬盘的设计,可被绝大部分操作系统的文件系统工具进行卷设置和治理,并提供工业规范的PCI和FC接口用于连贯主机或者服务器,然而最大问题利用范畴绝对较窄。

HDD数据读取形式

HDD的磁盘读取数据程序如下:

- 设施将须要读写的扇区和设施号码以及扫描多少个扇区通知磁盘

- 挪动磁头和转动盘片找到对应扇区。

- 读取数据,把数据写入缓冲。

- 如果所有的扇区扫描实现,读取的操作则算是实现。

HDD磁盘读写的要点

从逻辑上来看计算扇区扫描地位和扫描数量计算处理速度是很快的,将扇区内的数据读取或者写入的数据也是绝对较快的。

然而咱们晓得因为转速限度的和磁头和盘片物理扫描是十分慢的,整个读写的性能瓶颈是磁头扇区寻址和扫描磁盘所需的物理磁盘开销以及最初带来的随机读写性能的衡量。

读写形式

磁盘扫描的几种状况磁盘扫描的形式间接决定了数据处理读写速度:

- 程序扫描:程序扫描就是在一个磁道上间接划过间断的几个扇区,一次扫描就能够获取数据所以十分快。

- 屡次间断程序扫描:间断程序扫描是针对间断的几个扇区进行屡次扫描,这个工夫开销次要是在盘片的转动上,尽管仍然比拟快然而盘片转动仍然产生肯定提早。

- 随机读写:随机读写的开销次要在磁道来回寻址上,此时岂但可能会产生磁盘转动,磁头还须要寻找扩散的扇区,随机读写的效率是非常低的

⚠️留神:对于单次IO的拜访如果获取的数据量超过磁盘申请数据量的下限,则会把申请由单次的程序读写,拆分为屡次的程序扫描。

影响硬盘性能的因素

- 磁盘寻道工夫:磁盘的均匀寻道工夫个别在3-15ms。

- 磁盘转速:转速越快

- 磁盘自身的读写性能:和磁盘的设计厂商也有关系,随机读写强的HDD硬盘通常具备更好的IO性能,同时磁盘数据传输的越快传输量越大成果越好(废话)。

机械磁盘须要关注寻道工夫和旋转提早,当然HDD的羸弱的读写性能实际上大同小异。

通用块层

通用块层:指的是在Linux零碎对于HDD和SSD的形象。

HDD和SDD它们被称为块设施。块设施的拜访形式有两种,第一种是间接通过挂载的形式通过设施文件间接读写,第二种是依据文件系统对于磁盘进行封装以及提供疏导入口,当然大部分的软件应用第二种形式。

因为不同类型的块设施解决形式不同,这些设施的解决的须要依赖驱动程序的管制能力实现拜访,然而以咱们日常应用Windows零碎的教训,不可能是一个块设施一个驱动程序,不然咱们每一次退出新硬盘都要装一遍驱动,这样也太麻烦了。

那么操作系统如何解决这个问题?这也就是通用块层的作用了:

Linux和设施的交互流程

这一个流程图有很多细节能够理解,抽出任何一个层都能写一篇长文进去,这里咱们以简略理解IO调度器和磁盘预读机机制为主。

IO调度器和预读机制

在HDD中还有两个非常影响性能的机制,IO调度器和预读机制,然而留神针对HDD的预读要比 SSD的预读成果要好很多,因为有时候因为排序和预读容易导致SSD的负面优化。

⚠️留神:有时候咱们降级老设施将机械磁盘换固态的时候重装系统有可能呈现黑屏,这是因为局部旧主板会通过BIOS对机械磁盘调优,相似对于磁盘“预热”,然而这种预热会影响固态的启动,所以呈现相似状况能够查看BIOS是否有勾选相似的减速机械磁盘启动的选项。

IO调度器

IO调度器:是针对块设施拜访的时候将申请积攒到肯定的工夫之后在进行一次申请。

所以针对IO调度器次要有上面两个重要的工作:

- 合并:把对于多个扇区的拜访IO申请合并为一个申请。

- 排序:因为每个扇区都有编号,IO调度器会把间断的扇区拜访的IO进行排序之后再进行拜访,使得磁盘扫描更加趋近程序扫描。

⚠️留神:IO调度器个别针对并发线程读写或者异步IO过程中期待IO后果的时候应用IO调度器,

预读机制

磁盘的磁头在扫描数据的时候,不会只扫描设施要求的几个扇区,而是会多扫描周边的扇区,留神这个预读只有在程序扫描的时候发挥作用,当预读机制失效的时候如果发现预读的扇区在下一次拜访不会用到,间接抛弃即可。

Linux文件系统设计

简略的文件系统如何设计

从最简略的角度思考设计根本的文件系统咱们能够用一个惯例的文件读写举例。

最简略的文件系统蕴含上面的解决流程:

- 首先文件数据从0开始记录,每一 个文件在文件系统中有名称,大小和地位三条根本信息。

- 如果没有文件系统的辅助咱们须要自行思考文件的磁盘存储地位,须要从磁盘区域1到区域10依据文件的大小存储到块设施的对应地位,并且须要记录以后块的文件写入开始完结和完结为止,记录存储的数据大小。

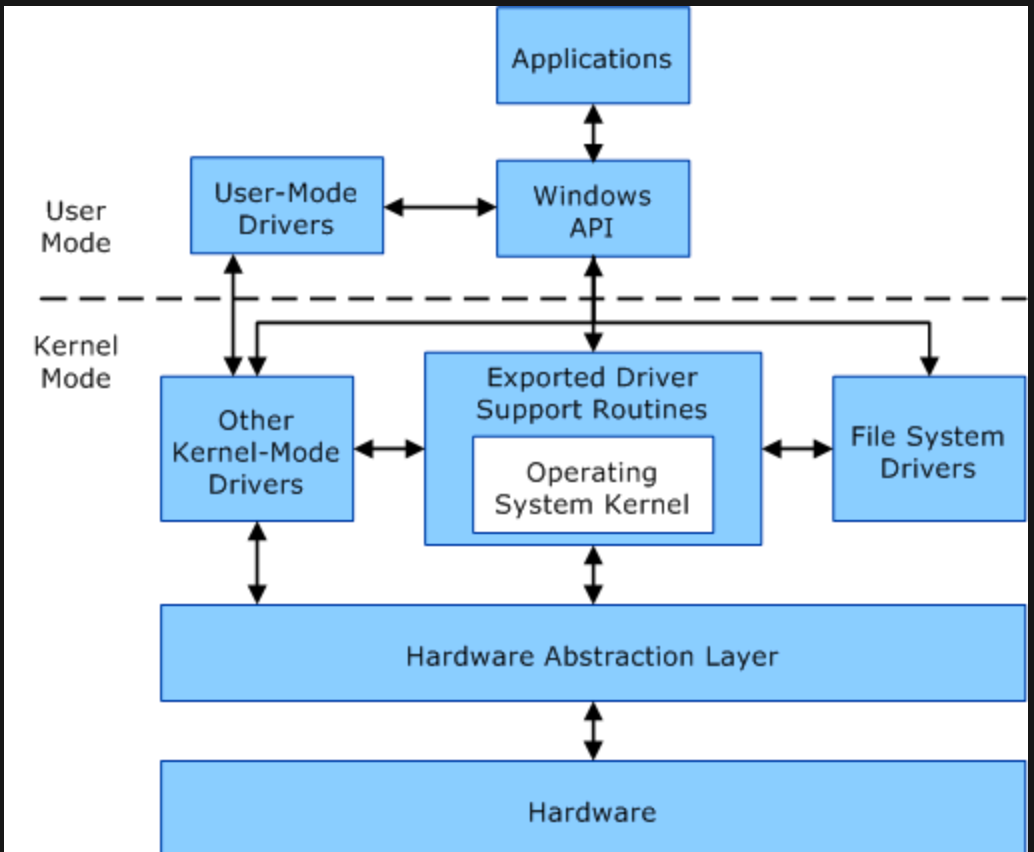

为什么会有“态”?

显然在晚期的单过程单用户操作系统中,是不存在态这个概念的。然而随着过程和用户的呈现,过后的计算机面临着一个重要问题,就是如何限度不同过程的操作的权限。

并不是所有的过程都能容许所有的内部用户操作的,因为不晓得将来会呈现哪些新的过程运作,所以工程师为了让零碎和用户的过程能够离开,就筹备让一些危险的操作只容许操作系统的过程去做,用户过程如果要做一些危险操作必须通过操作系统的“盘问”,之后再由操作系统去做。

最初“态”被设计为上面的模式:

模式切换

上面是Linux中用户态内核态硬件三者的关系:

用户态

是用户看得见的操作,比方想要读取某一个文件或者想要某一个文件改几个字,用户发送的这些指令通过内核转为机器码命令,而后在内核态对于磁盘进行IO操作。

也就是说 用户模式:发送指令操作 -> 内核模式,翻译用户指令为块设施能够辨认的命令 -> 硬件。

在下面设计的最简略的文件系统中,用户模式切换到内核模式进行文件治理只须要关怀文件大小,文件地位和文件名称。

内核态

只有领有零碎操作权限的操作系统才有权进行操作和拜访,个别都是执行一些零碎的外围工作。

硬件

硬件又被称为内部存储,这些操作只会和内核交互。

Linux文件系统构造

Linux的文件系统是树状结构设计,文件系统能够反对不同格局,不同文件系统的差异次要在最大反对操作文件大小,文件系统自身大小以及各种文件操作速度差异上。

文件系统存在ext2、ext3、ext4,它们的文件大小和存储模式和存储的地位都有差异,那么Linux是如何解决的呢?

Linux文件系统将应用接口的模式将文件IO操作进行形象,无论文件系统的构造模式如何变动,最终都是通过和上面提到相干的接口来实现交互的。

吐槽:有点像是设计模式的外观模式

- 创立删除:

create/unlink - 关上敞开:

open/close - 关上文件读数据:

read - 关上文件写数据:

write - 关上文件挪动到指定地位:

lseek - 非凡文件系统非凡操作:….

这一点和Linux块设施治理相似,在Linux与内部构造介绍中提到了块设施对于文件系统提供了通用层块进行形象,对于用户模式角度所看到的单块设施之间是没有差异的,而真正的驱动解决呈现在内核态中。

读取文件数据流程

在Linux中读取文件的流程如下:

- 各个文件系统通用解决。

- 文件系统专用解决,申请零碎调用对应解决指令。

- 设施驱动执行读写数据操作。

- 块设施驱动实现读写指令操作。

从逻辑构造来看整个交互流程很简略,然而实际上这都是Linux的工程师们一直致力的成绩。

数据和元数据

在Linux数据的品种分为元数据和数据,元数据和文件名称,文件大小,文件地位相干,这些参数用于内核态读取块设施作为参考,而数据则是咱们日常应用的视频数据,文本数据。

元数据除了下面的信息品种之外还蕴含上面的内容:

- 品种:判断文件是保留数据的一般文件还是目录还是其余文件,也就是文件类型。

- 工夫信息:文件的创立工夫、最初一次拜访工夫、最初一次批改工夫。

- 权限信息:Linux权限管制用户拜访。

咱们能够通过df命令和相干参数能够具体的理解文件系统的参数和运行状况,df是重要的运维命令,能够通过它理解到磁盘的容量状况。

g@192 ~ % df

Filesystem 512-blocks Used Available Capacity iused ifree %iused Mounted on

/dev/disk3s1s1 965595304 29663992 73597064 29% 500637 367985320 0% /

devfs 711 711 0 100% 1233 0 100% /dev

/dev/disk3s6 965595304 48 73597064 1% 0 367985320 0% /System/Volumes/VM

/dev/disk3s2 965595304 1034480 73597064 2% 2011 367985320 0% /System/Volumes/Preboot

/dev/disk3s4 965595304 31352 73597064 1% 48 367985320 0% /System/Volumes/Update

/dev/disk1s2 1024000 12328 985672 2% 3 4928360 0% /System/Volumes/xarts

/dev/disk1s1 1024000 15040 985672 2% 27 4928360 0% /System/Volumes/iSCPreboot

/dev/disk1s3 1024000 1240 985672 1% 39 4928360 0% /System/Volumes/Hardware

/dev/disk3s5 965595304 859395304 73597064 93% 1212174 367985320 0% /System/Volumes/Data

/dev/disk6s1 1000179712 807402240 192777472 81% 3153915 753037 81% /Volumes/Untitled

/dev/disk7s1 1953443840 1019557888 933885952 53% 497831 455999 52% /Volumes/Extreme SSD

map auto_home 0 0 0 100% 0 0 100% /System/Volumes/Data/home

//GUEST:@Windows%2011._smb._tcp.local/%5BC%5D%20Windows%2011 535375864 212045648 323330216 40% 26505704 40416277 40% /Volumes/[C] Windows 11.hidden

/dev/disk5s2 462144 424224 37920 92% 596 4294966683 0% /private/var/folders/wn/dvqxx9sx4y9dt1mr9lt_v4400000gn/T/zdKbGy磁盘配额

容量配额是磁盘治理中的外围,对于Linux文件管理系统来说有上面几种磁盘的配额形式:

- 用户配额:用户配额通常指的是/home,通常每一个用户家目录有固定的额度配比

- 子卷配额:限度名字为子卷的单元可用容量。

- 目录配额:能够通过特定目录的可用容量,比方共享目录的用户可用容量,ext4和xfs能够设置目录配额。

除了对于针对不同类型的配额之外,还须要思考零碎失常运行运作的零碎配额,也就是说如果给用户和零碎依照一刀切的形式配比100%的形式划分磁盘是一件危险的操作,对于一块磁盘放弃不超过80%是比拟常见设置。

文件系统意外复原

数据管理最常见的问题是数据不统一,诸如在没有实现写入的时候忽然断电,这种状况并不算特地少见,Linux提供了上面的两种形式解决断电数据状态不统一的问题:

- 日志:通常呈现在ext4和xfs的文件系统。

- 写时复制:通常为btrfs的实现。

日志形式:

应用日志解决状况要多一些,因为日志的形式具备肯定的可读性也不便复原,操作次要分为上面两个步骤:

- 数据批改之前把原子操作记录到日志当中。

- 宕机复原的时候依据日志记录内容还原文件状态。

如果异常情况产生在日志记录之前,能够间接抛弃写入一部分的日志并且回滚,当作文件状态没有更改过。而如果异样状态产生在原子操作的过程之后,则依据日志的记录把操作从新执行一遍即可。

古代文件系统更多的是来自于零碎的BUG产生的数据不统一问题,古代多应用SSD硬盘,SSD硬盘写入都十分快根本不会呈现写入时数据不统一问题。

写时复制形式:

不同文件系统对于写时复制的实现不同,介绍写时复制须要理解一些传统的比方ext4和xfs的文件系统工作机制。

这些文件系统在文件创建之后就会固定寄存到磁盘的某个地位,哪怕删除或者更新文件内容也只是在原有空间上进行操作。

而btrfs的写时复制的文件系统治理计划则比拟非凡,创立之后的文件每次更新都会放到不一样的地位。

写时复制就是说更新和写入都是一次相似“复制”的操作,当新数据写入实现再把援用更新即可,原有的内容只有不被新文件笼罩还是能够被找到。

如果在写入的时候忽然断电怎么办?

这时候数据是在另一个中央操作的,数据写入到一半也不会对旧数据有影响,如果是其余操作状况下比方写入刚实现没有更新援用的状况,此时只须要把援用更新一下即可。总之就是怎么样都不会影响原来的数据。

⚠️留神:其实磁盘实质上是没有删除这个概念的,计算机所谓的删除只是用户过程无奈通过惯例操作拜访被删除的文件所在地址而已,然而通过一些非凡解决还是有方法通过文件碎片复原原始文件的。

无奈复原的意外

如果是文件系统的BUG无奈复原的意外,对于不同的文件系统来说解决计划也不同。

简直所有的文件系统都有通用的fsck命令进行复原,然而这个命令定义是有可能复原数据状态。

上面是对于这个命令的介绍:

fsck 命令

Linux fsck(英文全拼:file system check)命令用于查看与修复 Linux 档案零碎,能够同时查看一个或多个 Linux 档案零碎。

语法

fsck [-sACVRP] [-t fstype] [–] [fsck-options] filesys […]

参数 :

- filesys : device 名称(eg./dev/sda1),mount 点 (eg. / 或 /usr)

- -t : 给定档案零碎的型式,若在 /etc/fstab 中已有定义或 kernel 自身已声援的则不需加上此参数

- -s : 依序一个一个地执行 fsck 的指令来查看

- -A : 对/etc/fstab 中所有列出来的 partition 做查看

- -C : 显示残缺的查看进度

- -d : 列印 e2fsck 的 debug 后果

- -p : 同时有 -A 条件时,同时有多个 fsck 的查看一起执行

- -R : 同时有 -A 条件时,省略 / 不查看

- -V : 具体显示模式

- -a : 如果查看有错则主动修复

- -r : 如果查看有错则由使用者答复是否修复

案例:

查看 msdos 档案零碎的 /dev/hda5 是否失常,如果有异样便主动修复 :

fsck -t msdos -a /dev/hda5fsck 命令存在的问题

然而这个命令看似很弱小,然而存在一些很重大的性能问题:

- 遍历文件系统并且查看文件系统的一致性同时还会修复不统一的中央,文件系统十分宏大复原速度会长达几个小时或者几天。

- 如果中途复原失败,解体的不只是机器。

- 修复胜利不肯定会复原到冀望状态,同时对于所有不统一的数据和元数据都会删除。

计算机存储档次简析

存储组件介绍

首先咱们来看看不同存储档次的介绍,包含下面提到的寄存器,高速缓存,内存以及他们三者之间的关系。

咱们从整体上看一下存储层次结构图:

留神⚠️:小字这些参数放到当初都是比拟老的了,咱们只须要简略了解从左到右速度由最快到快到慢到最慢的递进。

高速缓存:

高速缓存是位于CPU与主内存间的一种容量较小但速度很高的存储器。

内存的数据被读取之后,数据不会间接进入寄存器而是先在高速缓存进行存储,高速缓存通常分为三层,读取的大小取决于缓存块的大小,读取速度取决于不同层级高速缓存的容量。

高速缓存的执行步骤如下:

- 依据指令把数据读取到寄存器。

- 寄存器进行计算操作。

- 把运算后果传输给内存。

在下面的三个步骤中寄存器和高速缓存根本没有传输耗费,然而内存的传输就就慢不少了,所以整个流程运算的瓶颈也是内存的传输速度,这也是为什么应用高速缓存来解决寄存器和内存之间的微小差别。

高速缓存分为L1,L2,L3,在讲述理论知识之前,这里先举一个形象一点的例子不便了解:

- L1 cache:就如同须要工具在咱们的腰带上能够随时取用,所以要获取它的步骤最简略也最快

- L2 cache:就如同须要的工具放到工具箱外面,咱们如果须要获取要先关上工具箱而后把工具箱的工具挂到腰上能力应用。为什么不能从工具箱取出来再放回去呢?其实思考一下如果你须要频繁应用那得多累呀。另外工具箱尽管比腰上的空间大不少,然而也没有大特地多,所以L2 cache 没有比L1 cache大多少。

- L3 cache:L3相比L1和L2要大十分多,相当于一个仓库,咱们获取数据须要本人走到仓库去找工具箱而后放到身边,而后再像是下面那样执行一次,尽管仓库容积很大,然而须要操作的步骤最多,工夫开销也最大。

L1 cache上面是L2 cache,L2上面是 L3 cache,依据下面介绍L2和L3都有跟L1 cache一样的问题,要加锁,同步,并且L2比L1慢,L3比L2慢。

这里咱们再举例简述高速缓存的外部操作:

假如须要读取缓存块是10个字节,高速缓存为50个字节,R0、R1的寄存器总计为20个字节,当R1须要读取某个地址的数据时,在第一次读取数据的时候将10字节先加载到高速缓存,而后再由高速缓存传输到寄存器,此时R0有10字节的数据,如果下次还须要读取10个字节,同样因为高速缓存发现缓存中有雷同数据,则间接从高速缓存读取10个字节到R1中。

那么如果此时R0数据被改写会怎么办?首先CPU会先改写寄存器的值,改写寄存器值之后会同时改写高速缓存的值,此时如果存在从内存进来缓存块数据,在高速缓存中会先标记这些值,而后高速缓存会在某一个时刻把改写的数据同步到内存中。

如果高速缓存有余零碎会产生什么状况?

首先高速缓存会依据缓存淘汰机制淘汰末端起码应用的高速缓存,然而如果高速缓存的“变脏”速度很快并且高速缓存的容量总是有余,此时就会产生内存频繁写入高速缓存并且一直变动高速缓存的状况,此时就有可能会呈现可感知的零碎抖动。

留神⚠️:本局部探讨的内容全副为回写,改写的形式分为直写和回写,回写在高速缓存中存在肯定的提早,利用工夫积攒的形式定时改写的形式进行内存的同步刷新,而直写的形式则会在高速缓存扭转的那一刻立即改写内存的值。

如何掂量拜访的局限性呢?

简直所有的程序都能够分为上面两种状况:

- 工夫局限性:在肯定的工夫内缓存可能被拜访一次,然而能够隔一小段时间再一次拜访,常见的状况是一个循环中一直取值。

- 空间局限性:拜访一段数据的同时还须要拜访它周边的数据状况,有点相似磁盘的预读机制。

如果过程能够掂量并且把控好下面两个点,那么根本能够认为是一款优良的程序,然而现实情况往往不是如此。

小结:

- 高速缓存是利远远大于弊的一个设计。

- 数据不统一和数据同步高速缓存性能影响的次要问题。

- 高速缓存一旦被占满,则零碎处理速度会呈现肯定提早。

寄存器:

寄存器包含指令寄存器(IR)和程序计数器(PC),它属于中央处理器的组成部分,寄存器中蕴含指令寄存器和程序计数器以及累加器(数学运算)。

ARM走的是简略指令集,X86走简单指令集,尽管X86从当初来看是走到了止境,然而仍然占据市场主导地位。

简单指令集会蕴含十分多的寄存器实现简单运算,比方上面一些寄存器:

- 通用寄存器

- 标记寄存器

- 指令寄存器

如果有感兴趣能够将寄存器作为深刻X86架构的入口。

内存:

内存不仅仅是咱们熟知的电脑内存,从狭义上来说还包含只读存储,随机存储和高速缓存存储。

这里可能会有疑难为什么内存应用的最多却不如寄存器和高速缓存呢?

因为内存不仅仅须要和CPU通信还须要和其余的控制器和硬件打交道,管的事件越多效率天然越低,同时如果内存吃紧CPU还须要期待内存传输,当然这也能够反过来解释为什么须要高速缓存和寄存器。

除了下面提到的起因之外,还有比拟要害的起因是主板的总线带宽是有下限的并且须要共享给各路应用,比方南桥和其余的一些外接设备等等,同时总线也是须要抢占的,并不是分片应用。

其余补充

转译后备缓冲区

上面的内容来自百科的解释:

转译后备缓冲器(英语:Translation Lookaside Buffer,首字母缩略字:TLB),通常也被称为页表缓存、转址旁路缓存,为CPU的一种缓存,由内存治理单元用于改良虚拟地址到物理地址的转译速度。

目前所有的桌面型及服务器型处理器(如 x86)皆应用TLB。TLB具备固定数目的空间槽,用于寄存将虚构地址映射至物理地址的标签页表条目。为典型的联合存储(content-addressable memory,首字母缩略字:CAM)。

其搜寻关键字为虚拟内存地址,其搜寻后果为物理地址。如果申请的虚拟地址在TLB中存在,CAM 将给出一个十分疾速的匹配后果,之后就能够应用失去的物理地址拜访存储器。如果申请的虚拟地址不在 TLB 中,就会应用标签页表进行虚实地址转换,而标签页表的访问速度比TLB慢很多。

有些零碎容许标签页表被替换到次级存储器,那么虚实地址转换可能要花十分长的工夫。

过程如果想要拜访非凡的数据,能够通过上面提到的形式拜访逻辑地址:

- 对照物理页表通过查表的形式把虚拟地址转物理地址。

- 通过拜访对应的物理地址寻找理论的物理地址。

留神⚠️:这里的操作相似二级指针的拜访操作,如果想要高速缓存发挥作用必须是一级指针的查找才有意义,然而二级指针的查找是没有太大意义的。

转译后备缓冲器说白了就是用于减速虚拟地址到物理地址转化的一块非凡空间,目标是为了进步多级嵌套映射查找的速度。

页面缓存

留神下面提到的内容是页表缓存,这里是页面缓存。

页面缓存的作用是什么呢?咱们都晓得内部的硬件存储速度是最为迟缓的,通常应用程序操作硬盘中的数据都是事后把数据加载到内存再进行操作,然而数据并不是间接从磁盘拷贝到内存的,而是在内存和内部存储设备之间多了一层页面缓存。

页面缓存的读取步骤如下:

- 过程读取磁盘文本数据,寻找到相干数据之后将内容加载到页面缓存。

- 把页面缓存的内容复制到内存中,此时物理数据和内存以及页面缓存数据统一。

- 如果须要改写文件文本数据,首先会告诉页面缓存标记本人为“脏页”。

- 如果内存不足则空出闲暇的页面缓存给内存应用。

- 如果页面缓存和内存都有余就须要刷新“脏页”空出空间给内存持续应用。

- 通常状况下页面缓存会定期刷新缓存回写到磁盘中保持数据同步。

另外须要留神如果页面缓存始终没有过程拜访,页面缓存会始终“收缩”,如果页面缓存和内存始终不够用,就会一直的回写脏页并且产生性能抖动问题。

缓冲区缓存

缓冲区缓存很容易和页面缓存搞混,咱们只须要简略了解是对原始磁盘块的长期存储,也就是用来缓存磁盘的数据,比方设施文件直连内部的存储设备,U盘读写和外接磁盘的读写等等,这些读写通过缓存区缓存进行治理。

须要留神缓冲区缓存通常不会特地大(20MB 左右),这样内核就能够把扩散的写集中起来,对立优化磁盘的写入,比方能够把屡次小的写合并成单次大的写等等。

Linux中调优参数

理解下面各个组件的内容和细节之后,咱们来看几个简略的Linux调优参数。

回写周期

回写周期能够通过sysctl 的vm.dirty_writeback_centisecs 参数调整,然而留神这个值的单位比拟非凡,厘秒,这个参数默认设置为500,也就是5秒进行一次回写。

厘秒(英文:centisecond,符号cs),1厘秒 = 100分之1秒。

当然除非为了试验理解否则不要把这个值设置为0。

除了这个参数之外,还有个百分比的参数,当脏页的数量超过百分比之后就会触发脏页回写的操作避免性能激烈抖动,上面案例的10代表了10%。

上面是这个参数的内容:

vm.dirty_backgroud_ratio = 10如果想要应用字节的模式管制这个阈值,能够通过参数vm.dirty_background_bytes指定,如果这个参数为0则代表不开启这个配置。

脏页不容许始终存在,如果脏页积攒到肯定的量的时候会内核会触发回写操作,能够通过vm.dirty_ratio 管制,当达到此百分比内核会阻塞用户过程并且把所有的脏页回写。

vm.dirty_ratio除了设置百分比参数也能够通过字节限度,参数是vm.dirty_bytes。

除了这些不太罕用的参数之外,还有一些更为非凡的调优参数,

比方配置用于清空所有的页面缓存的操作方法是向/proc/sys/vm/drop_caches 写入3,为什么是写入3,这里留给读者本人寻找答案。

超线程

超线程(HT, Hyper-Threading)是英特尔研发的一种技术,于2002年公布。超线程的技术能够把一个外围伪装成两个外围对待,同时对于单核心的CPU,也能够享受模仿双核心的优惠,当然超线程技术不只是有益处,还有一个显著的毛病是多线程抢占以及线程上下文带来的开销,同时哪怕在最现实的状况下超线程的技术最多也只能晋升 20% -30%的,然而这个优化对于当年技术实力无限的状况下的技术优化和性能晋升成果是十分显著的。

<s>从此牙膏厂走向了挤牙膏的不归路</s>

小结

这部分内容更像是对于家用电脑常见的几个外围组建进行稍加深刻的介绍,学习这些内容不仅对于计算机的深刻了解是必要的,对于咱们日常选配电脑一些商家阐明也能有更深了解。

在其余的补充局部介绍了三个缓存,别离是转译后备缓冲,页面缓冲,缓冲区缓冲,这三者尽管名字相近然而外部负责的工作差异还是比拟大,介绍三者之后介绍了一些对于Linux的调优参数。

对于深刻X86架构来说,了解各个寄存器的外围工作机制比拟要害,而对于战将来的ARM应用的精简指令集对于整个生态倒退更为适合。

Linux内存治理

简略介绍

上面咱们就来简略介绍Linux内存治理的,在Linux中内存治理能够大抵了解为三个局部:

- 内核应用的内存

- 过程应用的内存

- 可用内存(闲暇内存)

其中除开内核应用的内存维持零碎失常运行不能被开释之外,其余均能够由操作系统自由支配。在Linux中领有free命令来专门查看内存的应用状况,执行的成果相似如下:

/opt/app/tdev1$free

total used free shared buffers cached

Mem: 8175320 6159248 2016072 0 310208 5243680

-/+ buffers/cache: 605360 7569960

Swap: 6881272 16196 6865076各个列的含意如下:

- total:零碎搭载物理内存总量,比方下面为8G。

- free:外表可用内存。

- buff/cache:缓冲区缓存和页面缓存,在计算机存储档次简析中提到了当内存不够能够应用开释缓存腾出空间给内存应用。

- availiable:理论能够应用的内存,计算公式很简略即

内核之外的可用总内存 - (free + buff/cache 最大能够开释的内存)。

除了列数据之外还有一个swap的行,这个参数的含意将在后文进行介绍。

Linux除了free命令之外,还有sar -r命令,能够通过这个参数指定采集周期,比方-r 1就是1秒采集一次。

集体目前应用的电脑为Mac,尽管是类Unix零碎然而没有free相干的命令,为此能够应用上面的命令进行简略的代替,然而不如free弱小。

在Mac中应用top -l 1 | head -n 10查看整体零碎运行状况。

MacBook-Pro ~ % top -l 1 | head -n 10

Processes: 604 total, 2 running, 602 sleeping, 3387 threads

2022/04/15 17:29:57

Load Avg: 2.84, 3.27, 5.68

CPU usage: 6.8% user, 14.18% sys, 79.72% idle

SharedLibs: 491M resident, 96M data, 48M linkedit.

MemRegions: 168374 total, 5515M resident, 235M private, 2390M shared.

PhysMem: 15G used (1852M wired), 246M unused.

VM: 221T vsize, 3823M framework vsize, 0(0) swapins, 0(0) swapouts.

Networks: packets: 312659/297M in, 230345/153M out.

Disks: 788193/14G read, 161767/3167M written.除此之外,能够在Mac中应用应用diskutil list:

~ > diskutil list

/dev/disk0 (internal):

#: TYPE NAME SIZE IDENTIFIER

0: GUID_partition_scheme 500.3 GB disk0

1: Apple_APFS_ISC 524.3 MB disk0s1

2: Apple_APFS Container disk3 494.4 GB disk0s2

3: Apple_APFS_Recovery 5.4 GB disk0s3

/dev/disk3 (synthesized):

#: TYPE NAME SIZE IDENTIFIER

0: APFS Container Scheme – +494.4 GB disk3

Physical Store disk0s2

1: APFS Volume mysystem 15.2 GB disk3s1

2: APFS Snapshot com.apple.os.update-… 15.2 GB disk3s1s1

3: APFS Volume Preboot 529.6 MB disk3s2

4: APFS Volume Recovery 798.6 MB disk3s3

5: APFS Volume Data 455.3 GB disk3s5

6: APFS Volume VM 24.6 KB disk3s6

/dev/disk6 (external, physical):

#: TYPE NAME SIZE IDENTIFIER

0: GUID_partition_scheme *512.1 GB disk6

1: Microsoft Basic Data 512.1 GB disk6s1

/dev/disk7 (external, physical):

#: TYPE NAME SIZE IDENTIFIER

0: GUID_partition_scheme *1.0 TB disk7

1: Microsoft Basic Data Extreme SSD 1.0 TB disk7s1

上面是`free`和`sar`这两个命令的输入后果对应关系:

> - total : 无对应

> - free :kbememfree

> - buff/cache :kbbufferrs + kbcached

> - available:无对应

如果内存应用过多,零碎为了空出内存可能呈现强制 `kill` 某个过程的操作,此操作是随机的并且无奈被监控,商用机器上执行这种操作是非常危险的,所以有局部的商用机器会开启一旦OOM间接把整个零碎强制敞开的操作。

## 内存调配形式及问题

内核分配内存的机会大抵有上面两种:

1. 创立过程。

2. 创立过程之后进行动态内存调配。

在过程创立之后如果过程还须要内核提供更多的内存,则能够向内核收回内存的申请申请,内核收到指令之后,则划分可用内存并且把起始完结的地址给过程进行应用。

然而这种要一点给一点的形式有上面几个常见的问题:

- 难以执行多个工作。

- 拜访其余用处的内存区域。

- 内存的碎片化。

> 留神⚠️:内存不仅仅须要和CPU通信还须要和其余的控制器和硬件打交道,分配内存给过程只是诸多工作的我的项目之一。

**难以执行多任务**

能够了解为过程频繁的须要申请内存的状况,这时候内核须要一直的操作分配内存给过程,整个工作相当于被单个过程给连累了。

另外如果多个工作呈现分配内存的区域刚好雷同,此时须要要实现内存调配给那个过程工作,则另一个过程期待也是能够了解的。

**内存碎片化**

起因是过程每次获取内存都须要理解这部分内容要涵盖多少区域否则就不能获取这些内存。

内存碎片化的另一个重大问题是明明有很多富裕的内存然而却拿不出一块残缺间断的空间给过程应用,导致一直的回收和调配操作。

**拜访其余用处的内存区域**

这种状况过程拜访被叫做缺页拜访中断,在后续的内容会进行介绍。

## 虚拟地址和物理地址

为了解决下面的问题,操作系统应用了虚构内容和物理内存的形式进行内存治理。

咱们须要理解三个概念:**地址空间、虚拟地址、物理地址**。

地址空间:指的是能够通过地址拜访的范畴都统称为地址空间。

虚拟地址:虚拟地址指的是过程无奈间接拜访到实在的物理内存地址,而是拜访和理论内存地址映射的虚拟内存地址,目标是为了爱护零碎硬件安全。

物理地址:也就是咱们理论内存对应的理论的物理地址。

这里举一个简略的例子:如果内核给过程调配100地址的虚拟内存地址,那么这个虚拟内存地址实上可能会指向理论的600物理地址。

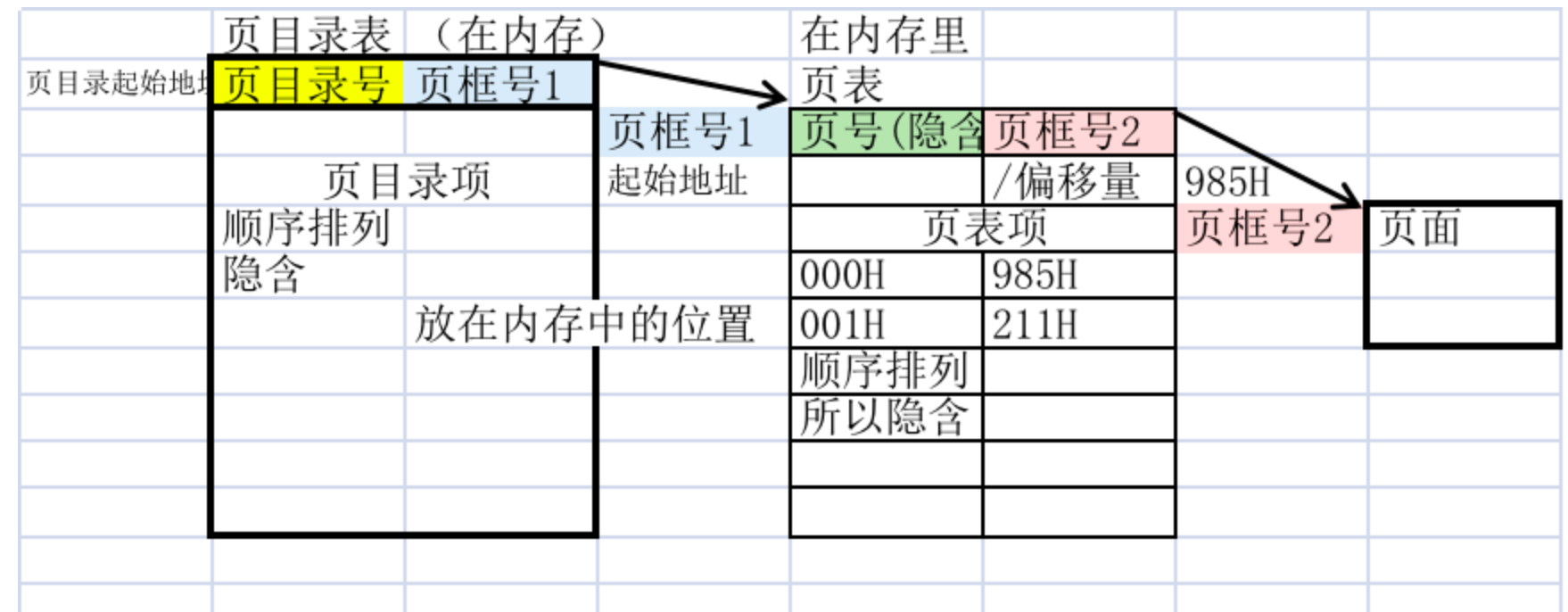

**页表**

实现虚拟地址到物理地址的映射依附的是页表,在虚拟内存当中所有的内存都被划分为页,一个页对应的数据条目叫做**页表项**,页表项记录物理地址到虚拟地址的映射关系。

在x86-64的架构中一个页的大小为4KB,过程在内存是有固定的起止地址的,那么如果呈现超出地址的页拜访,也就是拜访了没有虚拟地址和物理地址映射的空间会呈现什么状况呢?

如果呈现越界拜访,那么此时CPU会呈现**缺页中断**,并且终止在缺页中进行操作的过程指令,同时启动内核的**中断解决机构**解决。

> 留神⚠️:对应**拜访其余用处的内存区域**这个问题。

## 虚拟内存调配操作

虚拟内存的调配操作步骤咱们能够了解为几个外围的步骤:

- 内核寻找物理地址并且把须要的物理地址空间计算。

- 创立过程的页表把物理地址映射到虚拟地址。

- 如果过程须要动态内存治理,内核会调配新页表以及新的可用内存给过程应用,当然同时提供对应的物理内存空间。

> 物理分页应用的是请求分页的形式进行解决,这个调配的操作十分复杂。

**内存的下层调配**

在C语言中分配内存的函数是`malloc`函数,而Linux操作系统中用于分配内存的函数是`mmap`函数,这两者最大区别是`mmap`函数应用的是**按页**的形式调配,而`malloc`是依照**字节**的形式调配。

`glibc`通过零碎调用`mmap`申请大量的内存空间作为内存池,程序则调用`malloc`内存池申请调配出具体的内存供过程应用,如果过程须要再次获取内存则须要再次通过mmap获取内存并且再次进行调配操作。

在下层编程语言也是应用了相似的操作,首先通过`glibc`向内核申请内存执行虚拟内存的调配操作,而后`malloc`函数再去申请划分具体的内存应用,只不过更下层的语言应用了解析器和脚本进行覆盖而已,实际上通过层层翻译最终的操作仍然是下面提到的操作。

**虚拟内存是如何解决简略调配的问题的?**

这里咱们再次把下面三个问题搬出来,再解释虚拟内存是如何解决问题的:

- 难以执行多个工作:每个过程有独立的虚拟地址空间,所以能够编写专用地址空间程序避免多个工作阻塞期待的状况。

- 拜访其余用处的内存区域:虚拟地址空间是过程独有,页表也是过程独有。页表的另一个作用是限度能够避免以后的过程拜访到其余线程的页表和地址空间。

- 内存的碎片化:内存碎片化应用页表的形式进行调配,因为页表记录了物理地址到虚拟地址的映射,这样就能够很好的晓得未应用的空间都干了啥。

虚拟内存的其余作用:

- 文件映射

- 请求分页

- 利用写时复制的形式疾速创立过程

- 多级页表

- 规范大页

**小结**

这一部分简要论述Linux内存治理的入门了解局部,这一部分次要介绍了简要的内存调配形式,以及Linux对此通过页表的形式实现物理地址和虚拟地址的调配,最初论述了操作系统和编程语言也就是过程之间是如何分配内存的,具体的调配步骤和交互逻辑介绍。

# Linux内存治理优化

## 文件映射

通过之前的内容咱们理解到文件映射通过映射虚拟内存的形式实现,过程拜访内存对时候理论是文件对应的正本虚拟内存地址,既然拜访虚拟内存地位能够实现文件的批改映射,那么间接拜访物理内存也就是理论内存批改内容也是可行的。

如果晓得文件的具体地址,甚至能够间接定位到内存地址对于内容进行笼罩,在书中有一个C语言写的验证程序比拟有意思。

## 请求分页

过程向内核申请内存的通过**请求分页**的形式实现,之前提到过通过`mmap`的形式申请内存的形式尽管很不便然而是有问题的:

通常的内存调配形式有上面两种:

- 物理内存的间接申请和调配,高效。

- 句柄调配的形式,也就是页表对于虚拟内存和理论内存映射之后再给过程。

这两种调配形式都存在两个比拟显著的问题,那就是调配的时候如果申请了却没有应用会大量节约,另外一次glibc拜访须要超过过程的内存,然而过程此时很可能不会应用甚至可能基本不应用,此时很可能呈现**很大的过程治理大量被申请未应用内存**。

请求分页就是用来解决下面提到的问题的。

**请求分页理念**

为了更好了解请求分页须要先了解**分页的三种状态**:

- 未调配页表和物理内存给过程。

- 已调配页表然而未调配物理内存。

- 已调配页表和物理内存。

为了解决调配节约的问题,调配过程的内存仅应用一次调配形式,请求分页的外围是利用内核缺页中断的机制,当过程首次拜访到已调配然而没有没有调配物理内存的空间,对于此时内核会进行缺页中断解决,同时给过程真正申请物理内存进行调配动作,这样能够保障每次分配内存的动作都是无效的。

> 这种形式也相似懒加载的形式,即能够保障调配动作运行,过程无感知缺页中断的状况,仍然能够失常运行。

如果应用C语言依照请求分页的特点进行试验,能够发现当内存没有应用的时候即便显示曾经分配内存,然而理论**可用物理内存没有变动**。

另外分配内存失败分为虚拟内存调配失败,物理内存调配失败,这是因为“懒加载”的设计导致的,另外**虚拟内存有余不肯定会导致物理内存不足**,因为只有可用物理在调配空间小于虚拟内存那就是没法调配并且会调配失败。

## 写时复制

写时复制是利用`fork`的函数进步虚拟内存调配效率。

在文件系统的体现是`update`或者`delete`操作不会动原数据,而是用正本实现操作,当操作实现再更新援用,如果两头宕机断电,则用日志复原状态即可。

Linux 零碎的内存治理中调用 `fork` 零碎调用创立子过程时,并不会把父过程所有占用的内存页复制一份,而是首先与父过程共用雷同的页表,而当子过程或者父过程对内存页进行批改时才会进行复制 —— 这就是驰名的 `写时复制` 机制。

写时复制的流程如下:

- 在父过程调用`fork`的时候,并不是把所有内存复制给子过程而是递交本人的页表给子过程,如果子父过程只进行**只读**操作单方都会共享页表,然而一旦一方要扭转数据,就会立马**解除共享**。

- 在解除共享的时候会有如下操作

- 因为写入失去权限,所以会登程缺页中断,此时会切断用户态,保留以后过程状态并且进行内核态。

- 切换至内核态,内核干涉,执行缺页中断。

- 写入方的数据复制到另一处,并且把写入方的页表全副更新为新复制的内存并且赋予写入方写入权限,同时把之前共享的页表更新,并且把另一方刷新之后的页表从新连贯即可。(要害)

- 最初父子过程彻底写入权限和页表独立。然而之前解除共享的页表仍然能够自在读写。

> 留神⚠️:留神解除共享并不是所有的共享都解除,而是解除共享须要独立的局部,这种解决是。

另外还须要强调进行`fork`调用的时候并不会复制页表和内容,而是真正写入的时候会触发复制动作,这也是写时复制名字由来。

写时复制中如果只进行只读操作单方都会共享页表,然而一旦一方要扭转数据,就会立马解除共享。

## 替换内存

替换内存是Linux内核一种OOM状况下的弥补机制,作用也是为了缓解内存溢出和有余的问题,替换内存的实现依附的是**虚拟内存的机制**。

简略了解就是在物理内存尽管不够然而虚拟内存能够借用内部存储器也就是硬盘的一部分空间来充当物理内存应用,这一块分区叫做替换区,因为是借物理存储空间,这个操作也叫做换出。

另外如果借用的空间被开释则会立刻偿还,这种操作叫做换入,因为替换内存以页为单位,局部材料也叫页面调入和调出都是一个意思。

替换内存很容易认为是裁减物理内存的美妙形式,然而这里有一个实质的问题,那就是硬盘的访问速度和内存相比差的次方级别的差距,另外如果长期内存不足很容易导致替换内存一直的换入换出呈现显著的性能抖动。

**硬性页缺失和软性页缺失**

另外这类须要内部存储器的缺页中断在术语中被称之为**硬性页缺失**,绝对的不须要内部存储器的页缺失是**软性页缺失**,尽管实质都是内核在触发和残缺操作,然而硬性的缺失总归比软性缺失后果严重很多。

> 这里也要吐槽一下M1的各种偷硬盘缓存来进步性能的操作.....这也是为什么要把硬盘和CPU集成的起因之一。

## 多级页表

多级页表的设计外围是:**防止把全副页表始终保留在内存中是多级页表的关键所在,特地是那些不须要的页表就不应该保留。**

在X86-64架构当中,虚拟地址的空间大小约为128T,一个页的大小为4KB,页表的我的项目大小为8个字节。

所以一个过程的页表至多须要256GB内存!(8 * 128T / 4KB),然而咱们都晓得当初的电脑个别都是16GB内存为主。

那么零碎应该如何保护页表?这就引入了多层页表来进行治理,多级页表能够从最简略的角度当作一个多级的指针对待。

首先咱们能够思考,一个过程是否须要整个页表来治理内存?很显然是不须要的,这是引入多级页表的理由之一。

假如一个过程须要12M空间,顶端须要4M,数据局部占用4M,底部又是一些堆栈内容和记录信息,在数据顶端上方和堆栈之间是大量基本没有应用的闲暇区。

多级页表实际上就是大目录套小目录,和咱们的一本书一样,小目录负责小的过程,而遇到比拟大的过程就放到闲暇页比拟大的目录中实现调配操作,多级页表既能够高效的利用内存的同时,能够最大限度的缩小页表自身的数据结构在内存的占用,同时下面的例子也能够发现绝大多数的过程其实基本不须要太大的页表进行保护和治理。

最初从网上的材料翻阅中发现一张上面的图,对于多级页表的了解有肯定帮忙:

最初X86_64 应用了4层的页表构造,直当了解就是四级指针。

## 规范大页

随着过程虚拟内存和页表的应用,过程应用的物理内存也会减少。

依据请求分页和写时复制的概念,调用`fork`函数的时候会对于父子过程共享的页表进行拷贝,尽管这个拷贝动作不会占用物理内存,然而须要拷贝一份残缺的页表,当页表很大的时候也会造成性能节约。

为了解决这个问题,Linux提供了**规范大页**的机制,和他名字一样就是比一般的页表更大的页,利用这种页表能够减小过程页表所需的内存使用量,通过多级页表和规范大表能够无效的缩小整个页表项的数量。

**用法**:

C语言中应用`mmap`函数参数赋予 `MAP_HUGETLB` 标记,示意能够获取大页,然而更加罕用的形式是应用程序容许应用应用规范大页而不是这种手动切换的形式。

规范大页对于虚拟机和数据库等须要应用大量内存的应用程序是很有必要的,依据理论状况决定是否应用规范大页,通过这种设置能够缩小这一类软件内存占用,还能进步`fork`效率。

**通明大页**

通明大页是随着规范大页带来的附带个性,次要的作用是在间断的4KB页面如果合乎指定条件就能够通过通明大页的机制转为一个规范大页,以及在不满足规范大页条件的时候拆分为多个4KB页面。

**小结**

这部分从文件映射的内容引申了Linux两个重要的机制:**请求分页**和**写时复制**,目标实质上都是尽量减少过程对于内存的节约,然而须要留神的是这两种形式都是应用了内核模式的零碎中断机制来进行解决的,所以对于内核的性能以及稳定性要求十分高。

在之后的内容介绍了替换内存以及多级页表和规范大页几个内容,其中多级页表外部的细节十分的简单,通常须要对于操作系统底层有比拟相熟的认知能力齐全的理解这个页表的细节。

# 过程调度器

针对Linux过程调度有上面的思考:

- 每一个CPU同一时间只能调度一个过程。

- 每一个过程有*近乎相等的执行工夫。

- 对于逻辑CPU而言过程调度应用轮询的形式执行,当轮询实现则回到第一个过程重复。

- 过程数量耗费工夫和过程量成正比。

对于过程调度来说不能保障一个程序是间断实现的,因为CPU调度和过程切换,上下文也会呈现切换状况。

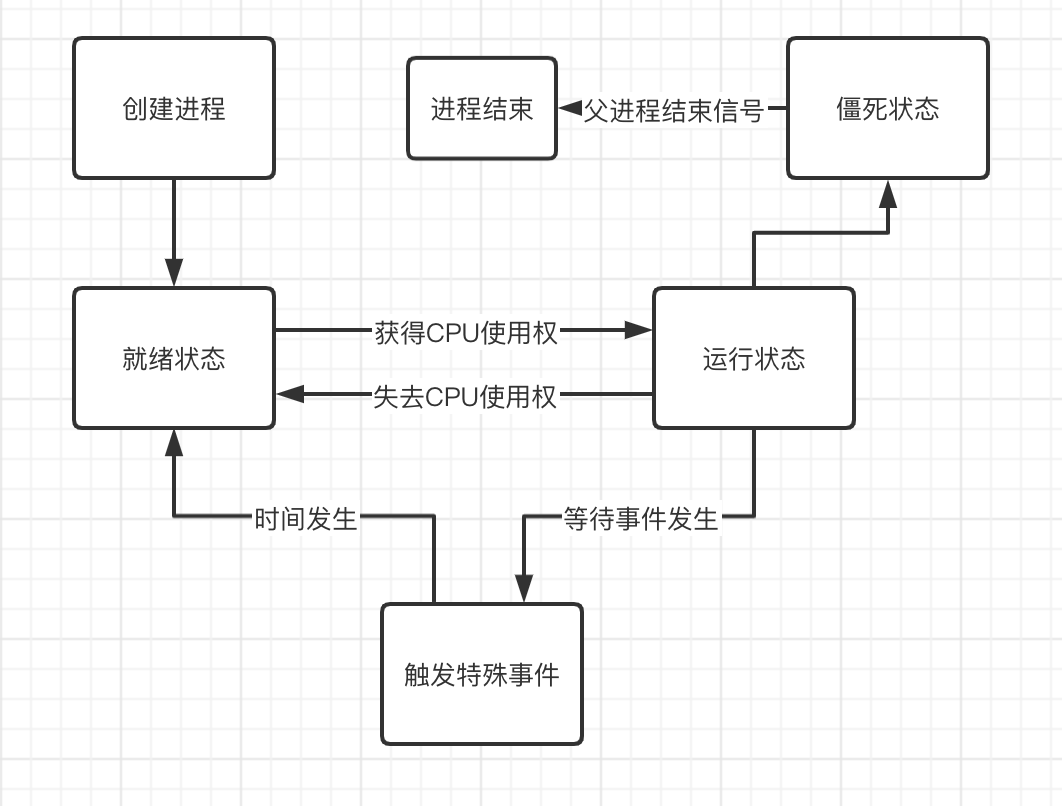

## 过程状态

对于大部分过程来说,当咱们不应用的时候少数处于睡眠状态。

除了睡眠状态之外,过程还有上面几种状态:

- 运行状态:取得CPU调度,执行过程工作。

- 僵死状态:过程期待完结,期待父过程回收。

- 就绪状态:具备运行条件,期待CPU调配。

- 睡眠状态:过程不筹备运行除非某种条件触发才会取得CPU调度调配。

处在睡眠态的过程触发运行态的条件如下:

- 内部存储器拜访。

- 用户键入或者鼠标操作触发事件。

- 期待指定工夫。

- 期待指定工夫。

通过`ps ax`命令能够查看以后的过程状态,上面的案例以集体的Mac电脑为例:

MacBook-Pro ~ % ps ax

PID TT STAT TIME COMMAND

32615 ?? Ss 0:00.11 /usr/libexec/nearbyd

32632 ?? Ss 0:00.51 /System/Library/CoreServices/Screen Time.app/Content

32634 ?? Ss 0:00.02 /System/Library/PrivateFrameworks/Categories.framewo

32635 ?? S 0:00.12 /System/Library/CoreServices/iconservicesagent

32636 ?? Ss 0:00.05 /System/Library/CoreServices/iconservicesd

32671 ?? S 0:02.44 /Applications/Microsoft Edge.app/Contents/Frameworks

32673 ?? S 0:02.86 /Applications/Microsoft Edge.app/Contents/Frameworks

32678 ?? Ss 0:00.17 /System/Library/PrivateFrameworks/UIFoundation.frame

32726 ?? S 0:00.07 /System/Library/Frameworks/CoreServices.framework/Fr

32736 ?? S 0:00.08 /System/Library/Frameworks/CoreServices.framework/Fr

32738 ?? S 0:00.75 /System/Applications/Utilities/Terminal.app/Contents

32739 ?? Ss 0:00.02 /System/Library/PrivateFrameworks/Categories.framewo

32746 ?? Ss 0:00.03 /System/Library/Frameworks/Metal.framework/Versions/

32740 s000 Ss 0:00.02 login -pf xxxxxx

32741 s000 S 0:00.03 -zsh

32750 s000 R+ 0:00.01 ps ax

`s`示意`sleep`,`d`示意此时可能在期待磁盘IO,然而如果长时间处于`d`状态则可能是磁盘IO期待超时或者内核可能产生故障。

上面是依据下面的介绍绘制的过程状态流转图

如果只执行一个过程同时在过程两头休眠过一次,那么此时休眠的过程在干什么?

过程会进入**空过程**的模式轮询,然而空过程不是没有事做,而是须要调用一些维持零碎运行的线程,为了保证系统失常稳固运行。

因为CPU和闲暇过程,所以同样会一直的切换睡眠态和静止态,静止态获取用户输出操作实现动作,睡眠态则执行一些轻量操作。

针对睡眠态的过程会有如下特点:

- 遵循同一时间CPU只能实现一个过程操作

- 睡眠态不占用CPU工夫。

## 吞吐量和提早

- 吞吐量:解决实现的过程数量 / 消耗工夫

- 提早:完结解决工夫 - 开始解决工夫

通过这两点能够总结几点规定:

吞吐量的下限是过程的数量多过逻辑CPU的数量,则再减少过程无奈减少吞吐量,另外过程中的提早总是均匀的,也就是说多个过程执行会取得近似均匀的提早,最初过程越多提早越高。

然而事实零碎没有那么多现实状况,少数状况是上面几种:

- **闲暇过程**:此时吞吐量很低,因为很多逻辑CPU都在睡眠状态。

- **过程运行态:此时没有就绪**:这种状态比拟现实,CPU能够安顿到下一次解决,尽管会延后开始执行进步吞吐量,然而可能会呈现CPU闲暇的状况。

- **过程运行态,同时就绪**:此时就如同赛跑,然而只有一个跑道,每一个过程轮流解决一会儿,所以此时提早变长。

另外因为很多程序编写都是单线程程序,**一核运行,多核围观**或者在过来更广泛。

优化吞吐量和提早的形式是应用 `sar` 命令找到运行工夫和开销最大过程,同时把一些死过程`kill`掉。

## 多CPU调度状况

分片工夫每一个过程用一个CPU工作,那么调配和调度CPU安顿工作又是如何的?

次要有两种形式,第一种是通过轮询**负载平衡**,另一种是**全局调配**,把任务分配给闲暇过程的逻辑CPU。

负载平衡是CPU遇到过程工作顺次安顿工作,当最初一个CPU安顿实现之后,则再回到第一个CPU进行调配,同时都是对于过程执行肯定的工夫,也就是说呈现CPU-A解决一部分,另一部分可能是CPU-B实现。

全局调配的形式比较简单,就是把任务分配给处于闲暇过程的逻辑CPU实现工作。

查看零碎逻辑CPU的命令如下:

`grep -c processor /proc/cpuinfo`

多核cpu通常只有在同时运行多个过程的时候才会发挥作用,然而并不是说有多少外围就有多少倍性能,因为大部分时候过程很少很多CPU都在睡眠态度

如果过程超过逻辑CPU数量,无论怎么减少过程都不会进步处理速度

最初处于睡眠状态的过程其实能够指定睡眠工夫,通过sleep函数调用实现过程休眠的操作。

**小结**

过程调度器的内容远没有下面介绍的简略,然而作为了解过程的切入点是不错的。

# 计算机程序概览

放到最初是因为集体认为算是这本书绝对没有什么价值的局部。

## 概览

广义上的计算机构造是:CPU,内存,外部设备,其中外部设备蕴含输入输出和内部外存储器以及网络适配器。

而从狭义上来看,计算机能够用抽象化的概念进行解释,则能够简略讲计算机分为三局部:

- 第一局部是应用程序,这些程序依靠于环境和载体。

- 第二局部就是运行程序的载体,负责管理系统调用,过程切换和设施驱动这些工作,同时负责重要的硬件形象的角色,为应用程序覆盖掉简单的底层保护工作。

- 最初一部分是硬件,这部分就是咱们广义的了解计算机的局部,这里不多介绍。

在硬件设施反复执行以下步骤:

- 输出设施或者网络适配器发动申请

- 读取内存命令,CPU上执行,把后果写入负责保留到内存区域

- 内存的数据写入HDD、SDD等存储器

而程序大抵则分为上面几种:

- 应用程序:让用户间接应用,为用户提供帮忙程序,例如计算机等办公软件,计算机上的办公软件,智能手机和其余利用。

- 中间件:辅助程序运行等软件,比方WEB服务器和数据库

- OS:管制硬件,为应用程序和中间件提供运行环境,Linux 叫做OS。

## 用户模式和内核模式

上面的内容能够认为是把之前的内容回顾一遍:

**用户模式**

用户过程拜访的时候都是用户模式,用户模式是受到爱护或者说权限受限的,只可能应用内核调配的内存和CPU进行操作,失去使用权则会处于期待的状况。

用户过程的一大特点是用户的空间只能用户过程应用,所以一旦有用户过程解体了,内核能够去把它给清理掉。因而加强零碎的鲁棒性。

**内核模式**

此模式下运行的代码对 CPU 和内存具备有限的应用权限,这个弱小的权限使得内核能够轻易腐化和解体整个零碎,所以内核应用的空间是只能被内核拜访的,其余任何用户都无权拜访。

**特点比照**

| **内核级线程特点** | **用户级线程的特点** |

| ------------------------------------------------------------ | ------------------------------------------------------------ |

| 1.过程中的一个线程被阻塞,内核能调度同一过程的其余线程(就绪态)占有处理器运行。<br/>2.多处理器环境中,内核能同时调度同一过程的多线程,将这些线程映射到不同的处理器外围上,进步过程的执行效率。<br/>3.应用程序线程在用户态运行,线程调度和治理在内核实现。线程调度时,控制权从一个线程扭转到另一线程,须要模式切换,零碎开销较大<br/> | 1.线程切换不须要内核模式,能节俭模式切换开销和内核资源。<br/>2.容许过程依照特定的须要抉择不同的调度算法来调度线程。调度算法须要本人实现。<br/>3.因为其不须要内核进行反对,所以能够跨OS运行。<br/>4.不能利用多核处理器长处,OS调度过程,每个过程仅有一个ULT能执行<br/>5.一个ULT阻塞,将导致整个过程的阻塞。<br/> |

> 对于用户线程阻塞在后续技术的倒退呈现了一种叫做**Jacketing技术**。

>

> 应用Jacketing技术把阻塞式零碎调用革新成非阻塞式的。当线程陷入零碎调用时,执行jacketing程序,由jacketing程序来查看资源应用状况,以决定是否执行过程切换或传递控制权给另一个线程。

>

> 也就是说Jacketing技术实现了当用户线程阻塞的时候更加灵便的进行切换,防止出现一个线程的阻塞导致多线程阻塞这种状况。

**用户模式切换到内核模式**:

个别是产生了中断或者无奈解决的零碎异常情况下呈现。

此时内核会剥夺用户过程的控制权进行解决, 并且执行一些内核的修复操作,比方缺页中断申请内存并且调配新的页表给过程,这种机制为请求分页的解决形式。

> 留神⚠️:更多细节能够回顾[过程调度器]查看无关过程调度的内容。

用户模式切换到内核模式个别会经验上面的步骤:

- CPU模式切换

- 保留以后的过程状态到外围栈。

- 中断异样程序调度解决

**内核模式切换到用户模式**:

当中断异样解决调度程序实现之后,内核模式会逐步转为用户模式运行,此时用户线程回从外围栈找回以后到过程状态,并且CPU运行模式也会执行为用户模式。

**模式切换的优劣比照**

其实这两个模式用最形象的概念就是**应用程序和零碎程序之间的差异**,因为对于用户来说模式切换是通明的,根本应用过电脑用过电脑程序,根本都经验过应用程序解体引发零碎解体的状况,此时就是一种用户模式到内核模式的切换。

用户模式的益处在于拜访和空间占用都是受到内核管控的,然而有一个很大的问题是一旦呈现中断异样就会产生用户模式和内核模式的切换,在通常状况下看起来没什么问题,然而随着过程须要的内存越来越大,每一次切换对于零碎带来影响和开销都是十分重大的。

在很多大型过程中,因为模式切换带来的问题也并不常见,更多状况下是用户编写的低质量或者问题代码呈现资源节约导致的问题。

**简略比照Windows**:

上面咱们类比Windows零碎的内核模式以及用户模式的切换,这里次要看看微软的官网文档是如何介绍的:

用户模式:过程享受专用的[虚拟地址空间](https://docs.microsoft.com/zh-cn/windows-hardware/drivers/gettingstarted/virtual-address-spaces),和Linux相似的 在用户模式下运行的处理器无法访问为操作系统保留的虚拟地址。

内核模式:在内核模式下运行的所有代码都共享单个[虚拟地址空间](https://docs.microsoft.com/zh-cn/windows-hardware/drivers/gettingstarted/virtual-address-spaces)。

其实简略比照一下就会发现实现机制都是相似的,只不过外部实现代码不同和细节不同而已,根本的个性都是类似的。

## C规范库

C规范库在很早就被国内设立为标准规范,哪怕过来这么多年仍然通用。

而C规范库中较为外围的组件是`glibc`,之前介绍过`glibc`是用户过程像内核申请内存的要害实现函数,应用glibc申请内存再应用mmap函数申请具体的内存,这部分内容能够浏览[内存治理]进行理解。

> glibc通过零碎调用向`mmap`申请大量的内存空间作为内存池,程序则调用`malloc`依据内存池调配出具体的内存应用,如果过程须要再次获取内存则须要再次通过mmap获取内存并且再次进行调配操作。

另外高级的编程语言同样依赖或者基于C规范库,比方Python的`ppidloop`就是如此,除此之外还有C++对于C规范库的进一步扩大等。

## OS提供的程序

上面列举一些OS提供的程序:

- 初始化零碎:`init`

- 变更零碎运作形式:`sysctl、nice、sync`

- 文件操作:`touch、mkdir`

- 文本数据处理:`grep、sort、uniq`

- 性能测试:`sar、iostat`

- 编译:`gcc`

- 脚本语言运行环境:`perl、python、ruby`

- shell:`bash`

- 视窗零碎:`x`

另外零碎调用通常也能够分为上面几种:

- 过程管制:[[010106 - 过程调度器]]

- 内存治理:[[010105 - Linux内存治理]]

- 过程通信:[[010106 - 过程调度器]]

- 网络管理(本书未波及)

- 文件系统操作:[[010103 - Linux文件系统设计]]

- 文件操作:[[010101 - Linux与内部构造介绍]]

# 写在最初

还是挺不错的一本书,尽管没有那些搬砖书那么零碎,然而对于初学者来说是个不错的切入书,这本书买实体书不是很划算,因为配图解说工作原理的内容比拟多,甚至让我感觉作者应该多一点文字描述......

# 附录

附录局部

## LBA(Logical Block Addressing)逻辑块寻址模式

### HDD常见寻址形式

**CHS寻址**

CHS寻址也被称为NORMAL 一般模式,此寻址模式是最早的 IDE 形式。

在硬盘拜访时,BIOS 和 IDE 控制器对参数不做任何转换。该模式反对的最大柱面数为 1024,最大磁头数为 16,最大扇区数为 63,每扇区字节数为 512,因而反对最大硬盘的容量为:

**512x63x16x1024=528MB**。

> ⚠️留神:最晚期的计算机仅仅只须要500多MB就够用,和当初的确是天差地别。

**LBA寻址**

LBA的寻址特点是地址不再和物理磁盘的地位一一对应,后面CHS寻址应用了三个要害参数:磁头地位,存储柱面地位,扇区地位三个参数利用三维的参数来计算容量,而LBA寻址则应用了一个参数进行寻址,同时由IDE管制计算柱面、磁头、扇区的参数等组成的逻辑地址转为物理地址。

LBA能够设置最大的磁头数为255,而其余参数和CHS寻址的模式相似,所以咱们对应下面的结算公式只须要把16改为255,最终后果如下:

512x63x255x1024=8.4G。

另外在晚期的LBA寻址中主板上大多数是28位的LBA寻址,而后面探讨了LBA的三维参数和物理地址不是一一对应的,而是通过IDE计算逻辑地址寻找最终的物理地址。

依据计算机的位操作咱们能够计算出逻辑块为2的28次方= 137,438,953,472个字节也就是137G,意味着最晚期的磁盘寻址极限为137G,当然这也是因为**过后的主板技术跟不上硬盘技术导致的**,并且过后的计算机应用人员用不到137G的容量。

当然要冲破这个限度也非常简单,把28位的寻址进步就能够间接反对更大容量的硬盘,通过倒退,**目前应用的都是48位LBA寻址形式**。

而48位LBA寻址形式的实践容量极限是144,115,188,075,855,872字节=144,000,000 GB!上亿的磁盘容量根本够目前应用。

因为LARGE、LBA寻址模式采纳了逻辑变换算法看上去比CHS简单不少,然而不少的材料、磁盘工具类软件中采纳的硬盘参数介绍和计算方法却还是依照相对而言比较简单的**CHS寻址模式**。

而LBA寻址模式说白了也是在CHS寻址模式上的改良,也须要向前兼容,因而CHS寻址模式是硬盘寻址模式的根底,了解CHS寻址模式HDD硬盘应用和保护还是很有用的。

**LARGE寻址**

LARGE 大硬盘模式,**在硬盘的柱面超过 1024 而又不为 LBA 反对时采纳**。LARGE 模式采纳的办法非常简单粗犷,就是把间接把**柱面数除以 2,把磁头数乘以 2**,其后果总容量不变形式寻址。

> ⚠️留神:LBA寻址到当初仍旧是支流。

### 容量和大小比照

- **CHS(或称为Normal)模式**: 适应容量≤504MB的硬盘。

- **LARGE(或称LRG)模式**: 适应504MB≤容量≤8.4GB的硬盘 。

- **LBA(Logical Block Addressing)模式**: 适应容量≥504MB的硬盘,但BIOS需反对扩大INT13H,否则也只能适应≤8.4GB的硬盘

**小结**

LARGE寻址模式把柱面数除以整数倍、磁头数乘以整数倍而失去的逻辑磁头/柱面/扇区参数进行寻址,所以示意的已不是硬盘中的物理地位,而是逻辑地位,然而这种计算形式显然比拟毛糙**应用比拟少**。

LBA寻址模式是间接以扇区为单位进行寻址的,不再用磁头/柱面/扇区三种单位来进行寻址。

但为了放弃与之前的CHS模式的兼容,通过逻辑变换算法,能够转换为磁头/柱面/扇区三种参数来示意,但示意的也和LARGE寻址模式一样已不是硬盘中的物理地位而是逻辑地位了。

# 参考资料

1. [磁盘I/O那些事](https://tech.meituan.com/2017/05/19/about-desk-io.html)

2. [为什么硬盘转速是5400或者7200这么奇怪的数字?7200转的硬盘肯定比5400快吗?](https://zhuanlan.zhihu.com/p/38847308)

3. [## 求硬盘的3种寻址模式 NORMAL LBA LARGE 具体介绍](http://www.360doc.com/content/14/0712/14/18521633_393882067.shtml)

4. [# 硬盘基本知识(磁头、磁道、扇区、柱面)](https://cloud.tencent.com/developer/article/1129947 )

5. [linux内存治理---虚拟地址、逻辑地址、线性地址、物理地址的区别](https://blog.csdn.net/yusiguyuan/article/details/9664887)

发表回复